Artigo

Feder desmonta o Saresp, mas usa a avaliação estadual para caçar diretores

Em São Paulo, o problema das avaliações em larga escala já não é a crença no seu poder de redimir males educacionais, mas a falsificação dos indicadores com fins eleitorais

Faz pelo menos 30 anos que o campo educacional mais alinhado à esquerda critica os usos políticos das avaliações em larga escala, sendo solenemente ignorado por aqueles que entram e saem dos governos com o aval de agentes econômicos que odeiam (mas fingem amar) a escola pública. Em São Paulo, estado mais rico do país, a crença tecnocrática no poder das avaliações externas de induzir a “melhoria” na educação chegou ao ponto de conduzir à falsificação grosseira com o objetivo de forçar a subida dos números e extrair vantagens eleitorais no curto prazo.

Um estudo recente da Rede Escola Pública e Universidade (REPU) e do Grupo Escola Pública e Democracia (Gepud) identificou um “paradoxo” na política de avaliação educacional do estado de São Paulo: ao mesmo tempo em que a Secretaria da Educação do Estado de São Paulo (Seduc-SP) criou uma nova avaliação educacional que desconstruiu as bases estatísticas que estruturavam e davam alguma confiabilidade ao Sistema de Avaliação do Rendimento Escolar no Estado de São Paulo (Saresp), ela vem utilizando essa avaliação sem validade estatística para justificar o afastamento de 225 diretores escolares, e também pretende utilizá-la para afastar professores das salas de aula no próximo ano.

A pesquisa identificou afastamentos de diretores em 222 escolas da rede estadual (três escolas tiveram dois diretores afastados), fundamentados num critério que previa punição dos gestores cujas escolas não exibissem uma melhora de aproximadamente 0,2 ponto na avaliação (em uma escala de 0 a 10). Um detalhe: a aplicação estrita desse critério (previsto na Resolução Seduc n. 12/2025) levaria à destituição os diretores de 2.509 unidades escolares; isto é, metade das escolas da rede estadual!

Para além das punições aos gestores, as notas médias obtidas pelas escolas também serviram para o cálculo de uma bonificação salarial aos professores, definindo-se dois patamares de metas: “ouro”, correspondente a um acréscimo de aproximadamente 0,3 ponto; e “diamante”, para escolas com subida de 0,6 ponto – sempre numa escala de 0 a 10. Apenas 9% (125 mil) dos alunos do Ensino Médio estudam nas chamadas escolas “ouro” e “diamante” da rede estadual. Para saber como essas escolas alcançaram esta condição de privilégio, a pesquisa investigou como as notas das escolas foram calculadas. Qual a margem de erro dessas notas? O que elas medem exatamente?

Não nos enganemos: aqueles que se ‘enquadram’ nos critérios de avaliação de hoje, serão perseguidos e expurgados amanhã

Em primeiríssimo lugar, consideramos que políticas de responsabilização (accountability) individual de diretores escolares por maus resultados ou de bonificação a professores de escolas que “entregaram” resultados são imorais, por razões já amplamente discutidas na literatura educacional. Ainda assim, se um governo decide enveredar por políticas de responsabilização baseadas em indicadores educacionais, esses indicadores devem ser produzidos com rigor, até para que os critérios sejam conhecidos e, no limite, questionados por aqueles que sofrem punições injustas.

É aí que mora o aparente paradoxo da política de avaliação da Seduc-SP. Embora o governo Tarcísio venha utilizando os resultados das avaliações para justificar a tomada de decisões executivas de alto impacto nas escolas, como afastar diretores, ele também alterou radicalmente a metodologia da avaliação estadual, a ponto de torná-la imprestável para subsidiar decisões executivas. Na prática, o governo desmontou a função pública do Saresp como avaliação de sistema, interrompendo uma série histórica de mais de uma década do Índice de Desenvolvimento da Educação do Estado de São Paulo (Idesp) para o Ensino Médio.

O Saresp acabou

Em 2023, o Saresp foi substituído no Ensino Médio pelo chamado Provão Paulista, exame de seleção para ingresso nas instituições estaduais de Ensino Superior envolvendo todas as disciplinas e séries. Nesse processo, a Teoria de Resposta ao Item (TRI) – metodologia utilizada no Saresp que permite a comparabilidade das provas ao longo do tempo – foi substituída pela Teoria Clássica dos Testes (TCT), que não permite comparar provas aplicadas em anos diferentes nem construir escalas de proficiência entre séries escolares distintas.

A TRI utiliza questões com parâmetros que medem o seu grau de dificuldade e poder de discriminação. Além disso, algumas questões são repetidas em diferentes provas, funcionando como “questões-âncora”, sejam elas relativas a séries ou a anos de aplicação distintos. Dessa forma, é possível calibrar o nível de dificuldade de cada prova, equalizando seus resultados e construindo uma escala de proficiência única. Só assim é possível comparar resultados de anos ou séries distintas e diagnosticar se houve melhora ou piora no desempenho em determinado conjunto de escolas.

Nada disso acontece com o Provão Paulista, como alertou o próprio presidente da Fundação Vunesp, contratada pelo governo para executá-lo:

“Foi feito esse alerta pela parte técnica da Vunesp, de que perderia a comparabilidade [das provas] ao longo do tempo. Uma coisa que vem de muito tempo vai se perder. Foi explicado isso para a Secretaria da Educação, então eles têm ciência disso. E, apesar disso, vai ser feito. (…) a Vunesp não tem nenhuma possibilidade de fazer diferente do que ela fez, que foi tão apenas alertar. Então, claro que muda, né? Não é a avaliação do sistema, é uma avaliação individual, é uma única prova. (Antonio Nivaldo Hespanhol, presidente da Fundação Vunesp, 23 ago. 2023)”

Em outras palavras, já era sabido desde o início que o Provão Paulista não é uma avaliação de sistema (com comparabilidade de proficiências ao longo de anos e séries), mas um processo seletivo equivalente a um vestibular tradicional.

O governo Tarcísio insistiu na mudança, e até chegou a realizar um procedimento de equalização das edições de 2023 e 2024 do Provão Paulista, restringindo-se apenas às provas do 3º ano do Ensino Médio e às disciplinas de Língua Portuguesa e Matemática. Isso quer dizer que os desempenhos das escolas calculados pela Seduc-SP continuam não sendo comparáveis de um ano a outro para todas as demais séries e disciplinas. Logo, não podem ser utilizados para medir qualquer evolução positiva ou negativa das escolas.

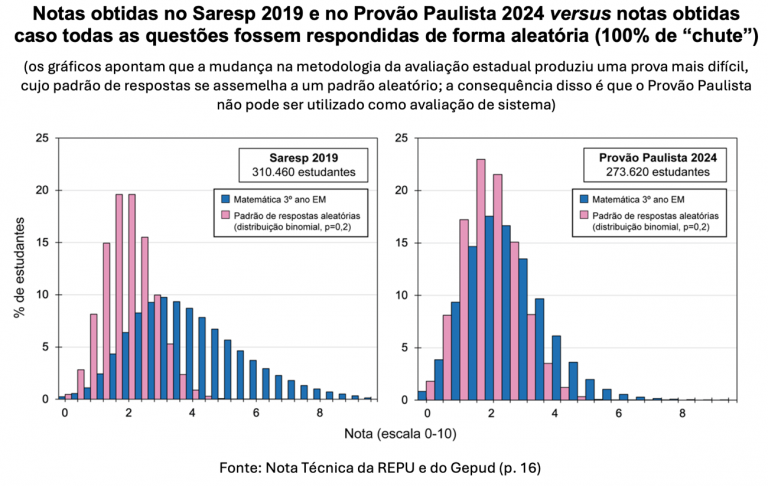

Dados levantados pela REPU e pelo Gepud indicam que o Provão Paulista apresenta níveis de acerto muito baixos em várias disciplinas, com médias próximas a 2,0, o que indica padrões de resposta semelhantes a um padrão aleatório, em que todos os estudantes “chutam” todas as respostas. Em 2019, a avaliação de Matemática do Saresp para o 3º ano do Ensino Médio já tinha resultados com notas baixas, mas o padrão de notas dos alunos era nitidamente diferente de um padrão aleatório. Já o padrão de respostas do Provão Paulista de 2024, é praticamente indistinguível de um padrão de 100% de “chute”.

Disso podemos extrair duas conclusões sobre o Provão Paulista: 1) ele é muito difícil para os níveis de proficiência dos estudantes da rede estadual; 2) ele não serve para avaliar o sistema de ensino. Também se pode especular que o Provão Paulista, a despeito de vender aos estudantes da rede estadual a possibilidade de ingresso nas prestigiadas universidades paulistas via um exame específico com reserva de vagas, esteja beneficiando muito mais os estudantes das Escolas Técnicas (ETECs) do Centro Paula Souza e do Instituto Federal de São Paulo (que também fazem o exame), especialmente para ingressar nos cursos mais concorridos. Essa hipótese deve ser testada em uma nova pesquisa.

Ao instituir o Provão Paulista, a Seduc-SP ampliou muito o alcance da avaliação, que passou a envolver todos os estudantes do Ensino Médio (antes eram só os do 3º ano) e todas as disciplinas (antes, apenas Língua Portuguesa e Matemática). O mesmo foi feito com o Saresp para os Anos Finais do Ensino Fundamental: todas as séries (6º ao 9º ano) e todas as disciplinas passaram a ser avaliadas, provavelmente com a intenção de responsabilizar os professores de cada disciplina e de cada turma pelos resultados. Uma ampliação tão brusca custou a perda do rigor estatístico da avaliação. Ou seja, ao mesmo tempo em que a Seduc-SP passou a produzir uma quantidade muito maior de índices, esses números são meros artefatos estatísticos; não possuem significado real.

Diante dos fatos, é inevitável perguntarmos por que a Seduc-SP piorou tanto a avaliação em larga escala estadual justamente quando pretendia utilizá-la como fundamento para ações de alto impacto político, como a destituição de diretores. Isso seria, então, um paradoxo? Vejamos.

Estímulo à fraude

A primeira explicação para a piora na qualidade da avaliação estadual é a pressa para produzir resultados favoráveis ao governo Tarcísio. A implementação de exames fundamentados na TRI é cara e demorada. Exige consolidar um grande banco de questões previamente testadas e parametrizadas (vide a complexidade de um exame como o Enem, baseado na TRI).

As autoridades de plantão também sabem que, mesmo que fosse possível, num tempo curto, desenvolver uma avaliação estadual censitária e anual para todas as séries e disciplinas baseada na TRI, a “melhoria” nos resultados desejada demoraria a chegar. Não obstante induzidas pelas avaliações externas, as mudanças nos processos escolares e pedagógicos não são determinadas pelos exames. É preciso fazer mais.

Melhorar salários, carreiras e condições de trabalho a docentes e gestores, manter uma infraestrutura escolar digna e garantir autonomia curricular e gestão democrática nas escolas são operações que qualificam o trabalho pedagógico nas escolas e afetam positivamente os resultados nas avaliações. Mas levam tempo. A pressa do governo em demonstrar as maravilhas de seu projeto daninho à educação pública se sobrepõe a tudo isso.

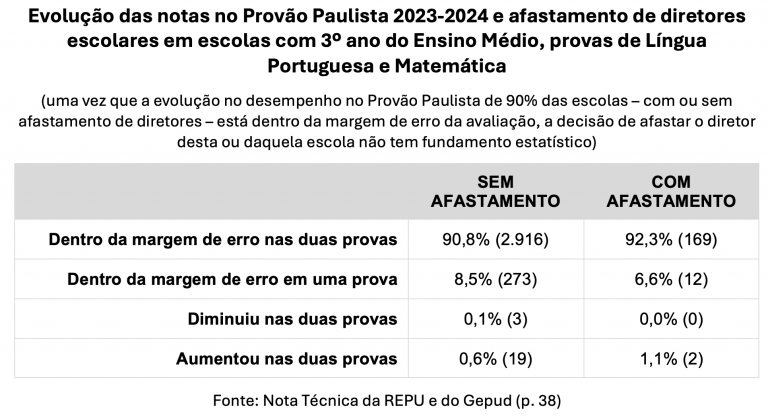

As notas das escolas que tiveram seus diretores destituídos são praticamente idênticas àquelas obtidas pelo conjunto das escolas da rede estadual. A pesquisa da REPU e do Gepud mostrou que o limiar de melhora estabelecido pela Seduc-SP (0,2 ponto) é, para a grande maioria das escolas, inferior à própria margem de erro da avaliação. Considerando as margens de erro, mais de 90% das escolas estaduais com 3º ano do Ensino Médio tiveram resultados estáveis entre 2023 e 2024 no Provão Paulista de Língua Portuguesa e Matemática – as únicas provas que passaram por um processo de equalização; e que, portanto, podem ser comparadas.

A variação da nota (para mais ou para menos) da imensa maioria das escolas estaduais foi menor do que a margem de erro da avaliação, sendo impossível afirmar se uma escola melhorou ou piorou de um ano para o outro. Esse resultado não surpreende educadores e pesquisadores: um ano é um tempo curto demais para aferir qualquer mudança real na proficiência dos estudantes de uma escola.

Isso também significa que o “critério” para a definição das escolas que tiveram diretores afastados é aleatório. Estando o limiar de 0,2 ponto dentro da margem de erro e em um cenário de estabilidade de desempenho da maior parte das escolas, é natural que mais ou menos a metade da rede descumpra o critério de desempenho definido pela Seduc-SP: é como um jogo de cara ou coroa.

Assim, o critério alargado da Seduc-SP deu ampla liberdade para que os 91 dirigentes regionais de ensino afastassem do trabalho quem bem entendessem. A diferença entre escolas “boas” e “ruins” é tão sutil, que a arbitrariedade sempre pode ser disfarçada reivindicando amparo num critério “objetivo”. Diante disso, alguns dirigentes de ensino decidiram simplesmente não afastar ninguém, enquanto outros – seja abertamente aliados ao governo, seja temendo por sua própria permanência no cargo – tentaram decidir com base em números sem sentido ou simplesmente aproveitaram a oportunidade para remover seus desafetos políticos das escolas.

Para o governo Tarcísio, pouco importa quais diretores serão removidos ou quais escolas serão denominadas “ouro” e “diamante”, contanto que uma pequena parte delas seja punida e outra bonificada, o que permite à Seduc-SP “motivar” a subida dos números à base do medo e da ameaça. A mesma estratégia vem sendo utilizada para forçar nas escolas o uso compulsório de plataformas educacionais, cujos indicadores de acesso e de conclusão de tarefas também geram ameaças e punições.

É nesse ambiente altamente controlado que – paradoxalmente? – abundam notícias de procedimentos fraudulentos, seja na realização da enorme quantidade de exercícios vinculados às plataformas digitais, seja no processo de aplicação das múltiplas avaliações oficiais, que ocupam um espaço desproporcional no cronograma das escolas e roubam preciosos dias de aula. O próprio Provão Paulista, que, por seu caráter de vestibular, deveria estar sujeito a um rigoroso controle contra fraudes, foi fraudado recentemente. A burla, apesar disso, só parece incomodar a Seduc-SP quando é noticiada.

Por exemplo, na prova de Matemática do Provão Paulista do 3º ano do Ensino Médio, 31 escolas da rede estadual mais do que duplicaram a sua nota entre 2023 e 2024, um feito tão extraordinário quanto estatisticamente improvável de ocorrer no curtíssimo intervalo de um ano. Algumas escolas chegaram a quadruplicar a nota! Esse tipo de fenômeno só poderia ocorrer em escolas com uma quantidade de estudantes muito pequena ou fraudando deliberadamente a avaliação. Dessas 31 escolas, 15 (48%) e 6 (19%) foram respectivamente agraciadas com os selos “ouro” e “diamante” da Seduc-SP.

Se, à primeira vista, fica-se com a impressão de que a Seduc-SP não tem conseguido controlar a burla disseminada na rede estadual, o estudo da REPU e do Gepud indica que, na verdade, é o próprio sistema de avaliação instituído pelo governo Tarcísio (ele próprio baseado na falsificação de indicadores) que estimula a burla e a fraude nas escolas. Não há dúvida de que a cobrança, mediante ameaças e recompensas, por resultados inalcançáveis e até mesmo impossíveis de mensurar no curto prazo gera como consequência a tentativa desesperada de obter o resultado demandado a qualquer custo. Esta é, provavelmente, a grande lição que a Seduc-SP procura ensinar.

Se cada diretor amedrontado com a potencial perda do cargo forçar o aumento dos números nas suas escolas (notas nas avaliações oficiais, indicadores de presença de estudantes etc.), o resultado líquido dessa operação será revertido em capital eleitoral para Tarcísio e em outras formas de capital para o secretário-empresário Renato Feder.

Àqueles que aceitam a chantagem e burlam as avaliações, reconfortados no benefício próprio imediato, fica o recado: os beneficiados reais são o governador Tarcísio de Freitas e secretário Renato Feder, duas figuras com apreço negativo pela escola pública. Não nos enganemos: aqueles que se “enquadram” nos critérios de avaliação de hoje, serão perseguidos e expurgados amanhã.

Tarcísio e Feder acabaram com o Saresp e não hesitarão em utilizar indicadores falsos para esmagar educadores, estudantes ou quem quer que seja. O desmonte da avaliação em larga escala em São Paulo – um patrimônio cultivado por décadas pela direita liberal – demonstra pela enésima vez que o projeto de perpetuação política do bolsonarisno não respeita nada nem ninguém.

Apoie o jornalismo que chama as coisas pelo nome

Muita gente esqueceu o que escreveu, disse ou defendeu. Nós não. O compromisso de CartaCapital com os princípios do bom jornalismo permanece o mesmo.

O combate à desigualdade nos importa. A denúncia das injustiças importa. Importa uma democracia digna do nome. Importa o apego à verdade factual e a honestidade.

Estamos aqui, há mais de 30 anos, porque nos importamos. Como nossos fiéis leitores, CartaCapital segue atenta.

Se o bom jornalismo também importa para você, nos ajude a seguir lutando. Assine a edição semanal de CartaCapital ou contribua com o quanto puder.

Leia também

As controvérsias da proposta de financiamento do novo Plano Nacional de Educação

Por Ana Luiza Basilio

Dois dedos de prosa com Ana Toni, diretora-executiva da COP30

Por Maurício Thuswohl

Em dez anos, aprendizagem no Ensino Médio encolhe e desigualdade cresce

Por Ana Luiza Basilio