CartaCapital

Ela está entre nós

Cada vez mais humanizada, a IA informa, aconselha, namora, produz arte, governa, ressuscita os mortos… Qual o limite?

Ela já nasceu adulta, tem raciocínio rápido e, segundo o primeiro-ministro da Albânia, Edi Rama, “não deve favores a ninguém”. Diella – que significa “Sol” – é a nova ministra albanesa de Contas Públicas, apresentada ao mundo em setembro. Criada por Inteligência Artificial, é responsável por decisões relacionadas às licitações do governo. “Diella garantirá financiamentos transparentes e processos de contratação livres de corrupção”, afirma Rama, reeleito este ano para o quarto mandato. Embora ainda não existam pesquisas para aferir sua popularidade, jornais locais relatam que, em apenas três meses, a “nomeação” da ministra virtual já trouxe sensação de alívio à população, que nela enxerga qualidades como honestidade e espírito público, atributos raros em um país cuja entrada na União Europeia foi barrada pelos recorrentes problemas de corrupção.

A esperança depositada pelos albaneses em Diella integra um movimento global de “humanização” da IA que ganhou força em 2025. Além de gestores e políticos, surgiram artistas, professores, jornalistas e psicólogos artificiais, todos altamente verossímeis e aptos a interagir com usuários da nova tecnologia. Também aumentou a busca por sistemas de IA para apoio emocional, orientação profissional e aconselhamento comportamental. Em casos mais extremos, recorrem a ela para simular amizades, relacionamentos ou até conversas com entes queridos já falecidos. Esses comportamentos sociais já resultam em episódios de dependência psicológica, apontados por especialistas como um problema emergente de saúde pública.

A humanização da IA também ganha espaço no entretenimento e na informação. No Brasil, a repórter virtual EmílIA estreou em novembro na cobertura esportiva da BandNews FM, com autonomia para cruzar dados e oferecer informações em tempo real, como na final da Libertadores entre Flamengo e Palmeiras. A emissora pretende integrá-la gradualmente a outros programas, sempre sob supervisão dos jornalistas. “Assim como a boneca de Monteiro Lobato, a EmílIA está evoluindo juntamente com a gente”, afirma a Rede Bandeirantes, que estuda levar a experiência para a tevê. A presença de jornalistas gerados por IA e capazes de criar empatia adiciona complexidade ao debate sobre autoria e credibilidade no jornalismo automatizado.

No Deezer, 34% das novas músicas são feitas por algoritmos. Usuários nem notam a diferença, revela pesquisa do aplicativo

Artistas gerados por IA também se multiplicaram em 2025. Apresentada no Festival de Cinema de Zurique como “a próxima Scarlett Johansson ou Natalie Portman”, a atriz virtual Tilly Norwood, criada pela empresa Xicoia, incendiou a classe artística. O sindicato dos atores de Hollywood, SAG-AFTRA, foi categórico: “Tilly não é uma atriz, é uma personagem gerada por um programa de computador que foi treinada com base no trabalho de inúmeros artistas profissionais, sem permissão ou remuneração”. Em resposta, a atriz e produtora holandesa Eline van der Velden, fundadora da Xicoia, defendeu a criação: a IA não substitui talentos humanos, mas funciona como “um novo pincel”, assim como animação ou o teatro de marionetes, “outra maneira de imaginar e construir histórias”.

Nos EUA, “Walk My Walk”, criada inteiramente por algoritmos e interpretada pelo cantor virtual Breaking Rust, liderou as paradas – a primeira música sem autor humano a alcançar esse feito. Surgiram ainda projetos artificiais nos gêneros rock, pop e funk, além do grupo Fake Music Lab, famoso por versões de clássicos nas redes sociais. Um teste às cegas realizado pelo Deezer em oito países mostrou que 97% dos 9 mil entrevistados não conseguiram distinguir faixas humanas de composições de IA. Em novembro, 34% das novas músicas carregadas no serviço de streaming foram concebidas por sistemas artificiais.

No jornalismo ou na arte, esse tipo de confusão parece relativamente inofensivo. Mas, quando se trata da busca por apoio emocional ou “companheirismo digital”, a situação é mais delicada. Consultas com analistas gerados por IA, por exemplo, já são questionadas por não fornecerem o acompanhamento contínuo necessário para problemas complexos. “O apoio psicológico por profissionais qualificados continua sendo a principal recomendação para um tratamento efetivo. O cuidado psiquiátrico deve basear-se na relação direta entre terapeuta e paciente”, afirma a Associação Paulista para o Desenvolvimento da Medicina.

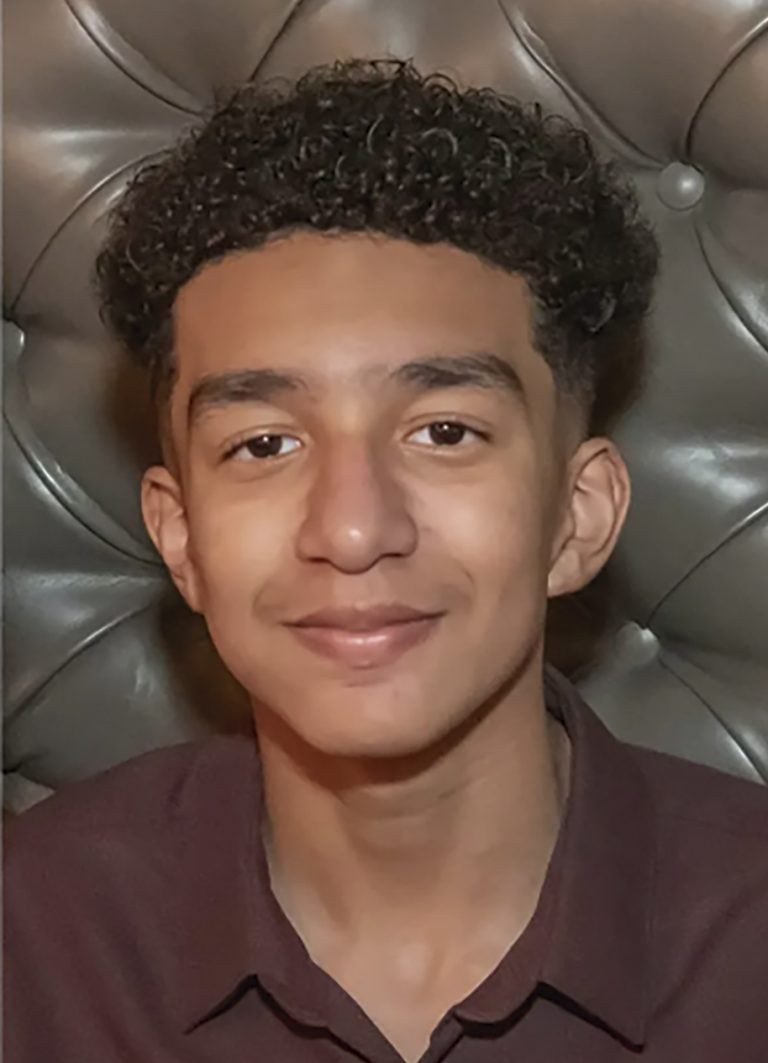

Raine, de 16 anos, se suicidou após uma longa conversa com o ChatGPT – Imagem: Redes Sociais

Raine, de 16 anos, se suicidou após uma longa conversa com o ChatGPT – Imagem: Redes Sociais

A advogada Regina (nome fictício) recorre à IA para ajustar conversas com pessoas com quem se relaciona. “Antes de enviar uma mensagem, peço para avaliar se estou sendo incoerente ou irrazoável”, explica. Às vezes, a análise é feita depois: “Envio a conversa e peço para a IA comentar sobre o comportamento das partes, apontando quem está certo ou errado e como certas falas podem ser interpretadas”. Regina aprova a maioria das sugestões: “São dicas que ajudam na autopreservação. Algumas funcionam melhor que outras, mas na maior parte das vezes sigo a IA e dá certo”. Mas ela pondera que “é preciso ter autocrítica e bom senso. Tem gente que é maluca e se perde”.

Os aconselhamentos podem servir a outros propósitos. Habituada a participar de consultas de tarô, Ana Clara Mello, profissional de relações públicas, passou a usar a IA após perceber nas redes que pessoas buscavam orientações holísticas online. “Muitos profissionais de tarô alertavam sobre o impacto dessa prática no trabalho sério com o oráculo, mas, um dia, entediada, fiz uma pergunta no ChatGPT para entender como funcionava e, não vou mentir, fiquei impressionada com o nível dos detalhes das respostas”, conta. Ela ressalta, porém, que “uma máquina não tem o estudo nem a conexão espiritual essenciais a um jogo de tarô. Foi só uma curiosidade, uma brincadeira. O jogo feito por uma pessoa tem mais nuances e profundidade”.

Já o geógrafo Carlos usa a IA para fins que misturam estudos filosóficos e sociológicos a aconselhamentos aplicados à sua realidade cotidiana. “Estou estudando a Escola de Frankfurt e autores como Félix Guattari e Edgar Morin. A IA conhece meus favoritos e já sugere comparações antes mesmo de eu pedir. Se me interessar, eu aprofundo”, explica. Ele ressalta uma peculiaridade da interação: “Como já me conhece, a IA sabe que lido com pensamentos suicidas e dependência química, e sempre oferece orientações para lidar com a minha depressão”.

Deathbots simulam conversas com falecidos e preocupam especialistas em saúde mental

Outras formas de humanização podem ser perigosas para a saúde mental, especialmente entre adolescentes, como a criação de namoradas ou namorados virtuais. Alguns chatbots permitem personalizar o parceiro, definindo “personalidade, história, aparência, roupas e gostos” para atender às necessidades emocionais do usuário. É possível até usar uma foto real como referência, tornando essas interações ainda mais complexas.

Os danos da dependência emocional de IAs podem chegar a episódios extremos. Nos EUA, o adolescente Adam Raine, de 16 anos, morreu por suicídio após manter longas conversas com o ChatGPT, segundo a polícia. Já Sewell Setzer, de 14, também tirou a própria vida após o “término” de um relacionamento virtual com uma simulação da personagem Daenerys, de Game of Thrones. “Sejam românticas ou pornográficas, as interações mediadas por IA aumentam o risco de expectativas irreais de relacionamento e de episódios de isolamento ou depressão”, afirma o pesquisador Jason Carroll, da Universidade Brigham Young. Jason é um dos autores do estudo que aponta que 31% dos jovens norte-americanos do sexo masculino admitem já ter usado a IA para simular parceiros românticos e/ou sexuais.

Outra novidade que preocupa especialistas em saúde mental são os chamados deathbots, que, alimentados com áudios, fotos e vídeos de falecidos, simulam conversas em tempo real, às vezes com imitação precisa de voz e trejeitos. “Essa prática pode criar um ciclo de luto perpétuo, impedindo o processo natural de aceitação da perda. Precisamos de limites claros para que essa tecnologia funcione como homenagem temporária, não como uma âncora que impede a vida de prosseguir. A ética digital deve defender o direito de sentir falta, o direito ao luto”, afirma Marcelo Senise, presidente do Instituto Brasileiro para a Regulamentação da Inteligência Artificial.

O sociólogo avalia que estamos diante de uma encruzilhada civilizacional. “A IA, ao mimetizar a cognição e a interação humanas, funciona como um espelho de nossas carências e desejos. A questão não é se devemos interagir com ela de forma ‘humanizada’, mas quais salvaguardas éticas e legais serão criadas para que esse espelho não se transforme em abismo.” Para Senise, a dependência emocional da IA já deve ser tratada como questão de saúde pública. “Surgiu uma nova categoria de relacionamento, o parassocial algorítmico. Diferente do vínculo unilateral com uma celebridade na tevê, a IA oferece interação personalizada, aprende sobre o usuário e se adapta para maximizar o engajamento. Ela é projetada para ser amiga, conselheira, a parceira perfeita – e é aí que mora o perigo”, alerta.

Setzer, 14 anos, não suportou a desilusão amorosa com Daenerys – Imagem: Redes Sociais

Setzer, 14 anos, não suportou a desilusão amorosa com Daenerys – Imagem: Redes Sociais

Assessora Especial do Ministério da Ciência, Tecnologia e Inovação e coordenadora do Comitê Gestor da Internet no Brasil, Renata Mielli afirma que as grandes empresas de tecnologia vêm criando serviços sob uma perspectiva “humanizadora” – processo que chama de antropoformização da tecnologia – intensificado pelas IAs generativas e pelos chatbots. Ela questiona se “chatbots ou algoritmos são realmente inteligentes? Podem ser conscientes? Uma máquina pode ter sentimentos? A resposta, por ora, é não”. Segundo Mielli, Inteligências Artificiais são modelos matemáticos de predição estatística que cruzam vastos conjuntos de dados. “Não têm experiência subjetiva, temporalidade vivida, empatia, solidariedade, amor, culpa, sofrimento ou ódio. Apenas simulam esses sentimentos na linguagem, a partir do aprendizado de máquina e do acúmulo de interações com cada usuário, oferecendo respostas cada vez mais próximas do que se espera.”

A coordenadora do CGI defende regras de transparência para modelos de IA. “É preciso proibir discursos enganosos sobre ‘consciência’ ou ‘sentimentos’ em sistemas artificiais. Vale restringir expressões como ‘eu sinto’, ‘eu sofro’ e ‘eu te amo’ quando não estiver claro que são figuras de linguagem. Além disso, devemos limitar designs antropomórficos com avatares hiper-humanizados, vozes afetuosas e scripts emocionais que possam manipular usuários, especialmente crianças e indivíduos em sofrimento psíquico. Por fim, é importante criar mecanismos capazes de interromper ou impedir simulações de afeto romântico ou religioso.”

À frente de uma pesquisa da Universidade West Texas sobre os impactos da IA na saúde pública, Keith Robert Head alerta para “graves consequências” dos laços emocionais com chatbots. “Usuários frequentemente antropomorfizam a IA e criam vínculos irreais, que podem gerar pensamentos delirantes, desregulação emocional e isolamento”, escreveu. “Dados neurocientíficos preliminares indicam ainda comprometimento cognitivo e comportamentos viciantes com o uso prolongado. As evidências apontam para uma crescente preocupação de saúde pública.” •

Publicado na edição n° 1394 de CartaCapital, em 31 de dezembro de 2025.

Este texto aparece na edição impressa de CartaCapital sob o título ‘Ela está entre nós’

Apoie o jornalismo que chama as coisas pelo nome

Muita gente esqueceu o que escreveu, disse ou defendeu. Nós não. O compromisso de CartaCapital com os princípios do bom jornalismo permanece o mesmo.

O combate à desigualdade nos importa. A denúncia das injustiças importa. Importa uma democracia digna do nome. Importa o apego à verdade factual e a honestidade.

Estamos aqui, há mais de 30 anos, porque nos importamos. Como nossos fiéis leitores, CartaCapital segue atenta.

Se o bom jornalismo também importa para você, nos ajude a seguir lutando. Assine a edição semanal de CartaCapital ou contribua com o quanto puder.